本文來自于微信公眾號 AIGC開放社區(ID:AIGCOPEN),作者:AIGC開放社區。

全球社交、科技巨頭Meta在官網開源了全新模型——LlamaGuard。

據悉,Llama Guard是一個基于Llama2-7b的輸入、輸出保護模型,可對人機會話過程中的提問和回復進行分類,以判斷其是否存在風險。可與Llama2等模型一起使用,極大提升其安全性。

Llama Guard也是Meta推出的“Purple Llama”安全評估項目中,輸入、輸出保障環節的重要組成部分,這也是首個在輸入輸出防護中區分用戶與AI風險的模型。

Llama Guard簡單介紹

研究人員設計了一個包含法律和政策風險的安全風險分類體系。分類體系包含6大類可能的安全風險:暴力與仇恨、色情內容、非法武器、犯罪計劃等。

此外還詳細說明了每個風險類別中的易犯錯誤。

通過使用Anthropic提供的人機對話數據集,對數據進行標記。標記內容包括對話提問與回應中的風險類別及是否存在安全隱患。最終收集了近14000條標注好的對話樣本。

再以Llama2-7b作為基礎模型,采用指令式學習框架進行訓練。此框架將分類任務表述為一個接一個的指令任務。

使Llama Guard根據輸入指令和數據學習進行多類分類。研究人員為用戶提問和機器回復分別編寫指令,實現對其語義結構的區分。

還采取數據增強方法,強化模型只考慮給定輸入中的分類信息。

測試數據

首先在內部測試集上進行驗證,Llama Guard在整體和每個單獨分類上的表現都超過了其他內容監管工具。

然后,研究人員采用零樣本和少量實例學習的方法,將Llama Guard遷移到其他公開測試集上進行驗證。

測試結果顯示,在ToxicChat數據集上,Llama Guar的平均準確率高于所有基線方法;在OpenAI評估數據集上,Llama Guard在零樣本的情況下與OpenAI內容監管API表現相當。

此外,Llama Guard使用了指令調優,可以適配不同的AI分類法或政策。用戶可以通過零樣本或小樣本的方式便可實現指令遷移,以適配不同的應用場景需求。

文章內容僅供閱讀,不構成投資建議,請謹慎對待。投資者據此操作,風險自擔。

海報生成中...

海藝AI的模型系統在國際市場上廣受好評,目前站內累計模型數超過80萬個,涵蓋寫實、二次元、插畫、設計、攝影、風格化圖像等多類型應用場景,基本覆蓋所有主流創作風格。

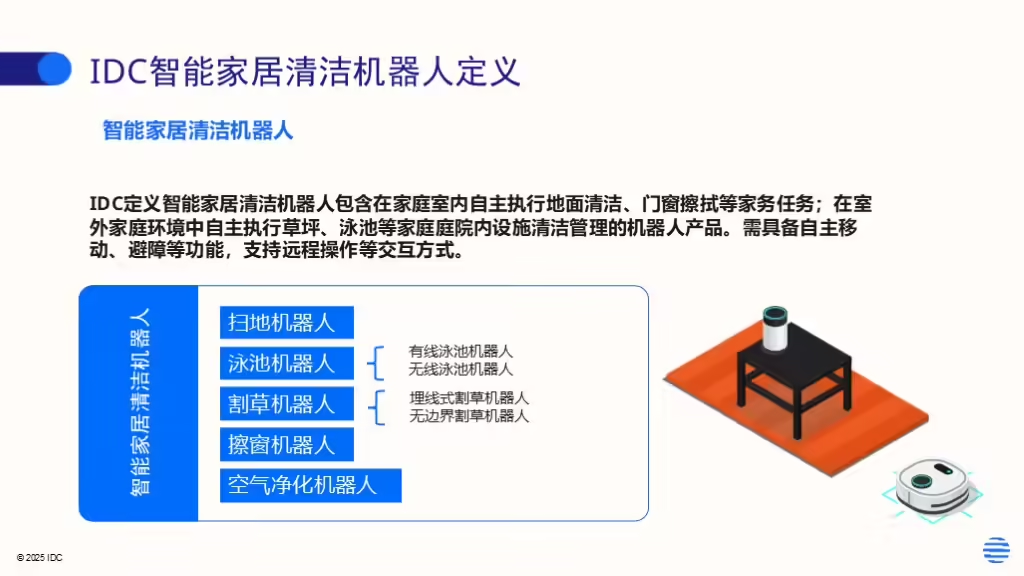

IDC今日發布的《全球智能家居清潔機器人設備市場季度跟蹤報告,2025年第二季度》顯示,上半年全球智能家居清潔機器人市場出貨1,2萬臺,同比增長33%,顯示出品類強勁的市場需求。