來源:內(nèi)容編譯自theregister。

如果您認(rèn)為人工智能網(wǎng)絡(luò)還不夠復(fù)雜,那么 Nvidia、AMD 和英特爾等公司推出的機(jī)架式架構(gòu)將帶來新的復(fù)雜性。

與通常使用以太網(wǎng)或 InfiniBand 的橫向擴(kuò)展網(wǎng)絡(luò)相比,這些系統(tǒng)核心的縱向擴(kuò)展結(jié)構(gòu)通常采用專有的或至少是新興的互連技術(shù),可為每個(gè)加速器提供幾個(gè)數(shù)量級(jí)的更高帶寬。

例如,Nvidia 的第五代 NVLink 互連為每個(gè)加速器提供比當(dāng)今以太網(wǎng)或 InfiniBand 高 9 倍到 18 倍的總帶寬。

這種帶寬意味著 GPU 的計(jì)算和內(nèi)存可以池化,即使它們物理上分布在多個(gè)不同的服務(wù)器上。Nvidia 首席執(zhí)行官黃仁勛將 GB200 NVL72 稱為“一塊巨型 GPU”,這可不是開玩笑。

向這些機(jī)架規(guī)模架構(gòu)的轉(zhuǎn)變在很大程度上受到 OpenAI 和 Meta 等模型構(gòu)建者的需求的推動(dòng),它們主要針對(duì)超大規(guī)模云提供商、CoreWeave 或 Lambda 等新云運(yùn)營商以及需要將其 AI 工作負(fù)載保留在本地的大型企業(yè)。

考慮到這個(gè)目標(biāo)市場,這些機(jī)器的價(jià)格不菲。據(jù)The Next Platform 估計(jì),單個(gè) NVL72 機(jī)架的成本為 350 萬美元。

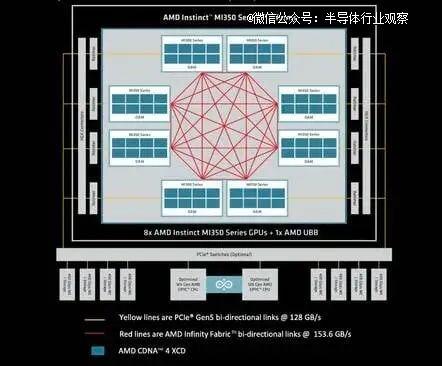

需要明確的是,實(shí)現(xiàn)這些機(jī)架級(jí)架構(gòu)的縱向擴(kuò)展架構(gòu)并非新鮮事物。只是到目前為止,它們很少擴(kuò)展到單個(gè)節(jié)點(diǎn)之外,并且通常最多支持 8 個(gè) GPU。例如,以下是 AMD 最新發(fā)布的MI350 系列系統(tǒng)中的縱向擴(kuò)展架構(gòu)。

如您所見,每個(gè)芯片都以全對(duì)全拓?fù)浣Y(jié)構(gòu)連接其他七個(gè)芯片。

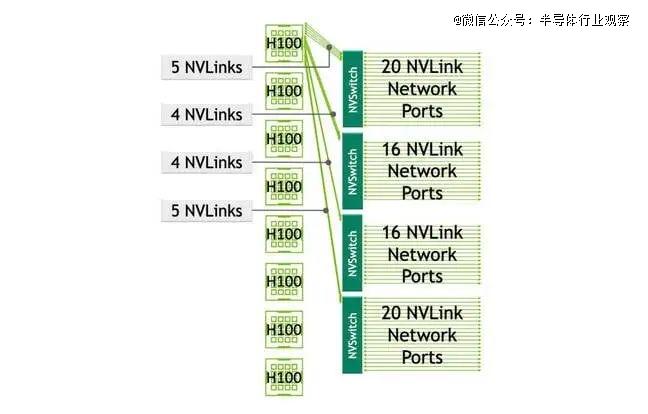

Nvidia 的 HGX 設(shè)計(jì)沿用了其四 GPU *** 系統(tǒng)的基本模板,但為其更常見的八個(gè) GPU 節(jié)點(diǎn)增加了四個(gè) NVLink 交換機(jī)。雖然 Nvidia表示這些交換機(jī)的好處是可以縮短通信時(shí)間,但也增加了復(fù)雜性。

隨著向機(jī)架規(guī)模的轉(zhuǎn)變,同樣的基本拓?fù)浣Y(jié)構(gòu)只是簡單地?cái)U(kuò)大了規(guī)模——至少對(duì)于 Nvidia 的 NVL 系統(tǒng)而言是如此。對(duì)于 AMD 來說,全網(wǎng)狀網(wǎng)絡(luò)根本不夠用,交換機(jī)變得不可避免。

01

深入探究 Nvidia 的 NVL72 擴(kuò)展架構(gòu)

我們稍后會(huì)深入探討 House of Zen 即將推出的 Helios 機(jī)架,但首先我們先來看看 Nvidia 的 NVL72。由于它上市時(shí)間較短,我們對(duì)它了解得比較多。

簡單回顧一下,該機(jī)架式系統(tǒng)擁有72 個(gè) Blackwell GPU,分布在 18 個(gè)計(jì)算節(jié)點(diǎn)上。所有這些 GPU 都通過 18 個(gè) 7.2TB/s 的 NVLink 5 交換芯片連接,這些芯片成對(duì)部署在 9 個(gè)刀片服務(wù)器上。

據(jù)我們了解,每個(gè)交換機(jī)ASIC都擁有72個(gè)端口,每個(gè)端口的雙向帶寬為800Gbps或100GB/s。與此同時(shí),Nvidia的Blackwell GPU擁有1.8TB/s的總帶寬,分布在18個(gè)端口上——機(jī)架上的每個(gè)交換機(jī)一個(gè)端口。最終的拓?fù)浣Y(jié)構(gòu)看起來有點(diǎn)像這樣:

這種高速全互連結(jié)構(gòu)意味著機(jī)架中的任何 GPU 都可以訪問另一個(gè) GPU 的內(nèi)存。

02

為什么要擴(kuò)大規(guī)模?

據(jù) Nvidia 稱,這些海量計(jì)算域可顯著提升 GPU 的運(yùn)行效率。對(duì)于 AI 訓(xùn)練工作負(fù)載,這家 GPU 巨頭估計(jì)其 GB200 NVL72 系統(tǒng)的速度比同等數(shù)量的 *** 系統(tǒng)快 4 倍,盡管在相同精度下,組件芯片的性能僅高出 2.5 倍。

同時(shí),對(duì)于推理,Nvidia表示其機(jī)架規(guī)模配置的速度提高了 30 倍——部分原因是可以采用不同程度的數(shù)據(jù)、管道、張量和專家并行性來利用所有內(nèi)存帶寬,即使模型不一定受益于所有內(nèi)存容量或計(jì)算。

話雖如此,Nvidia 基于 Grace-Blackwell 的機(jī)架中 VRAM 為 13.5TB 到 20TB,AMD 即將推出的 Helios 機(jī)架中 VRAM 為 30TB 左右,這些系統(tǒng)顯然是為服務(wù)于像 Meta(顯然已延遲)兩萬億參數(shù)的 Llama 4 Behemoth 這樣的超大模型而設(shè)計(jì)的,它將需要 4TB 內(nèi)存才能在 BF16 上運(yùn)行。

不僅模型越來越大,上下文窗口(可以將其視為 LLM 的短期記憶)也越來越大。例如,Meta 的 Llama 4 Scout 擁有 1090 億個(gè)參數(shù),并不算特別大——在 BF16 級(jí)別上運(yùn)行時(shí)僅需要 218GB 的 GPU 內(nèi)存。然而,其 1000 萬個(gè) token 的上下文窗口則需要數(shù)倍于此的內(nèi)存,尤其是在批量大小較大的情況下。

03

推測 AMD 首 款擴(kuò)展系統(tǒng) Helios

毫無疑問,這就是為什么 AMD 也在其 MI400 系列加速器中采用了機(jī)架式架構(gòu)。

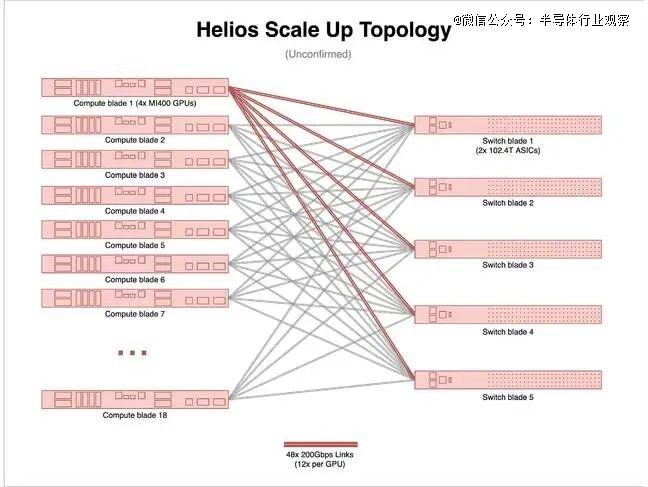

在本月初的 Advancing AI 大會(huì)上,AMD發(fā)布了Helios 參考設(shè)計(jì)。簡而言之,該系統(tǒng)與 Nvidia 的 NVL72 非常相似,將于明年上市,配備 72 個(gè) MI400 系列加速器、18 個(gè) EPYC Venice CPU 以及 AMD 的 Pensando Vulcano NIC。

關(guān)于該系統(tǒng)的細(xì)節(jié)仍然很少,但我們知道它的擴(kuò)展結(jié)構(gòu)將提供 260TB/s 的總帶寬,并將通過以太網(wǎng)傳輸新興的 UALink。

如果您還不熟悉,新興的 Ultra Accelerator Link 標(biāo)準(zhǔn)是 NVLink 的開放替代方案,適用于擴(kuò)展網(wǎng)絡(luò)。Ultra Accelerator Link 聯(lián)盟最近于 4 月發(fā)布了其首 個(gè)規(guī)范。

Helios 每塊 GPU 的雙向帶寬約為 3.6TB/s,這將使其與 Nvidia 第 一代 Vera-Rubin 機(jī)架式系統(tǒng)(也將于明年推出)相媲美。至于 AMD 打算如何實(shí)現(xiàn)這一目標(biāo),我們只能猜測——我們也這么做了。

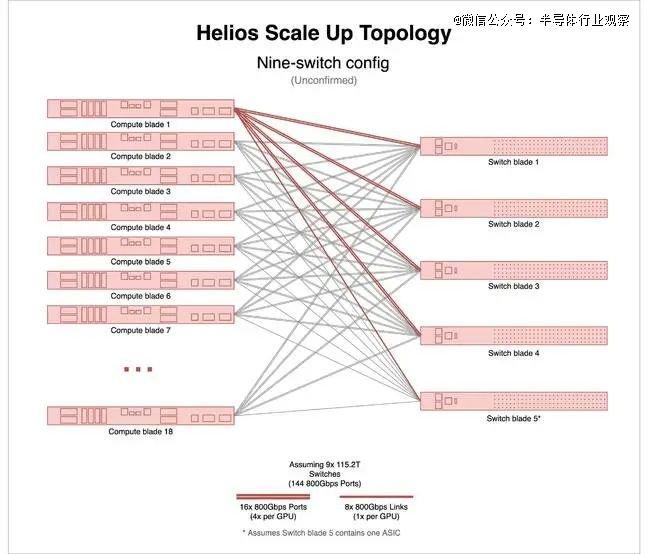

根據(jù)我們在 AMD 主題演講中看到的內(nèi)容,該系統(tǒng)機(jī)架似乎配備了五個(gè)交換刀片,每個(gè)刀片上似乎有兩塊 ASIC。由于每個(gè)機(jī)架配備了 72 塊 GPU,這種配置讓我們感覺有些奇怪。

最簡單的解釋是,盡管有 5 個(gè)交換刀片,但實(shí)際上只有 9 個(gè)交換 ASIC。要實(shí)現(xiàn)這一點(diǎn),每個(gè)交換芯片需要 144 個(gè) 800Gbps 端口。這對(duì)于以太網(wǎng)來說略顯不尋常,但與 Nvidia 在其 NVLink 5 交換機(jī)上的做法相差無幾,盡管 Nvidia 使用的 ASIC 數(shù)量是 NVLink 5 的兩倍,帶寬卻只有 NVLink 5 的一半。

其結(jié)果將是與 Nvidia 的 NVL72 非常相似的拓?fù)浣Y(jié)構(gòu)。

棘手的是,至少據(jù)我們所知,目前還沒有能夠提供這種帶寬水平的交換機(jī)ASIC。幾周前我們深入研究過的博通Tomahawk 6,其性能最接近,擁有多達(dá)128個(gè)800Gbps端口和102.4Tbps的總帶寬。

需要說明的是,我們不知道 AMD 是否在 Helios 中使用了 Broadcom——它恰好是少數(shù)幾個(gè)公開披露的非 Nvidia 102.4Tbps 交換機(jī)之一。

但即使 Helios 塞進(jìn)了 10 顆這樣的芯片,你仍然需要另外 16 個(gè) 800Gbps 以太網(wǎng)端口才能達(dá)到 AMD 宣稱的 260TB/s 帶寬。這到底是怎么回事呢?

我們猜測 Helios 使用的拓?fù)浣Y(jié)構(gòu)與 Nvidia 的 NVL72 不同。在 Nvidia 的機(jī)架式架構(gòu)中,GPU 通過 NVLink 交換機(jī)相互連接。

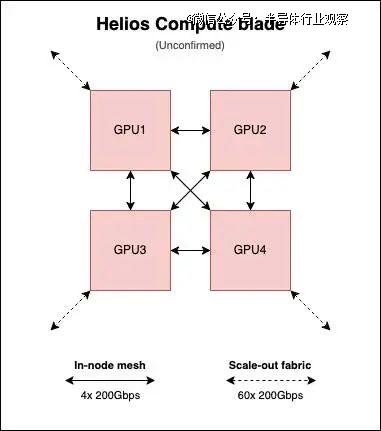

然而,看起來 AMD 的 Helios 計(jì)算刀片將保留 MI300 系列的芯片到芯片網(wǎng)格,盡管有三個(gè)網(wǎng)格鏈接將每個(gè) GPU 連接到其他三個(gè)。

當(dāng)然,這都只是猜測,但數(shù)字確實(shí)相當(dāng)吻合。

根據(jù)我們的估算,每個(gè) GPU 為節(jié)點(diǎn)內(nèi)網(wǎng)格分配 600GB/s(12 條 200Gbps 鏈路)的雙向帶寬,并為擴(kuò)展網(wǎng)絡(luò)分配約 3TB/s(60 條 200Gbps 鏈路)的帶寬。也就是說,每個(gè)交換刀片的帶寬約為 600GB/s。

如果您覺得端口數(shù)量太多,我們預(yù)計(jì)每個(gè)計(jì)算刀片將聚合成大約 60 個(gè) 800Gbps 端口,甚至可能 30 個(gè) 1.6Tbps 端口。這有點(diǎn)類似于英特爾對(duì)其Gaudi3 系統(tǒng)的做法。據(jù)我們了解,實(shí)際布線將集成到盲插式背板中,就像 Nvidia 的 NVL72 系統(tǒng)一樣。所以,如果您之前還在為手動(dòng)連接機(jī)架網(wǎng)絡(luò)而煩惱,現(xiàn)在您可以放心了。

我們可以看到這種方法的一些好處。如果我們的預(yù)測正確,那么每個(gè) Helios 計(jì)算刀片都可以獨(dú)立運(yùn)行。與此同時(shí),Nvidia 有一個(gè)單獨(dú)的 SKU,名為 GB200 NVL4,專門針對(duì) HPC 應(yīng)用,它將四個(gè) Blackwell GPU 連接在一起,類似于上圖,但不支持使用 NVLink 進(jìn)行擴(kuò)展。

但同樣,我們無法保證這就是 AMD 正在做的事情——這只是我們最 好的猜測。

04

擴(kuò)大規(guī)模并不意味著停止擴(kuò)大規(guī)模

您可能會(huì)認(rèn)為,AMD 和 Nvidia 的機(jī)架式架構(gòu)所支持的更大的計(jì)算域意味著以太網(wǎng)、InfiniBand 或 OmniPath — — 是的,它們回來了! — — 將退居次要地位。

實(shí)際上,這些可擴(kuò)展網(wǎng)絡(luò)無法擴(kuò)展到機(jī)架之外。Nvidia 的 NVL72 和 AMD 的 Helios 等系統(tǒng)中使用的銅質(zhì)跨接電纜根本無法達(dá)到那么遠(yuǎn)。

正如我們之前所探討的,硅光子技術(shù)有潛力改變這一現(xiàn)狀,但該技術(shù)在集成方面也面臨著自身的障礙。我們認(rèn)為,Nvidia 并非出于自身意愿而規(guī)劃 600kW 機(jī)架的發(fā)展路線,而是因?yàn)樗A(yù)計(jì)這些規(guī)模化網(wǎng)絡(luò)擺脫機(jī)架束縛所需的光子技術(shù)將無法及時(shí)成熟。

因此,如果您需要超過 72 個(gè) GPU(如果您正在進(jìn)行任何類型的訓(xùn)練,那肯定需要),您仍然需要一個(gè)橫向擴(kuò)展架構(gòu)。實(shí)際上,您需要兩個(gè)。一個(gè)用于協(xié)調(diào)后端的計(jì)算,另一個(gè)用于前端的數(shù)據(jù)提取。

機(jī)架規(guī)模似乎也沒有減少所需的橫向擴(kuò)展帶寬。至少對(duì)于其 NVL72,Nvidia 本代產(chǎn)品仍堅(jiān)持 1:1 的 NIC 與 GPU 比例。通常,每個(gè)刀片還會(huì)配備另外兩個(gè) NIC 或數(shù)據(jù)處理單元 (DPU) 端口,用于傳統(tǒng)的前端網(wǎng)絡(luò)將數(shù)據(jù)移入和移出存儲(chǔ)等等。

這對(duì)于訓(xùn)練來說很有意義,但如果你的工作負(fù)載可以容納在單個(gè) 72 GPU 的計(jì)算和內(nèi)存域中,那么對(duì)于推理來說可能并非絕 對(duì)必要。劇透:除非你運(yùn)行的是某個(gè)龐大的專有模型,且其細(xì)節(jié)尚不清楚,否則你很可能可以做到。

好消息是,我們將在未來 6 到 12 個(gè)月內(nèi)看到一些高基數(shù)開關(guān)(high radix switches)進(jìn)入市場。

我們已經(jīng)提到過博通的Tomahawk 6,它將支持從64個(gè)1.6Tbps端口到1024個(gè)100Gbps端口的各種帶寬。此外,英偉達(dá)的Spectrum-X SN6810也將于明年上市,它將提供多達(dá)128個(gè)800Gbps端口,并將采用硅光技術(shù)。與此同時(shí),英偉達(dá)的SN6800將配備512個(gè)MPO端口,每個(gè)端口速率可達(dá)800Gbps。

這些交換機(jī)大幅減少了大規(guī)模 AI 部署所需的交換機(jī)數(shù)量。要以 400Gbps 的速度連接 128,000 個(gè) GPU 集群,大約需要 10,000 臺(tái) Quantum-2 InfiniBand 交換機(jī)。而選擇 51.2Tbps 以太網(wǎng)交換機(jī),則可以有效地將這一數(shù)字減半。

隨著轉(zhuǎn)向 102.4Tbps 交換,這個(gè)數(shù)字縮減到 2,500,如果您可以使用 200Gbps 端口,則只需要 750 個(gè),因?yàn)榛鶖?shù)足夠大,您可以使用兩層網(wǎng)絡(luò),而不是我們在大型 AI 訓(xùn)練集群中經(jīng)常看到的三層胖樹拓?fù)洹?/p>

文章內(nèi)容僅供閱讀,不構(gòu)成投資建議,請謹(jǐn)慎對(duì)待。投資者據(jù)此操作,風(fēng)險(xiǎn)自擔(dān)。

海報(bào)生成中...

海藝AI的模型系統(tǒng)在國際市場上廣受好評(píng),目前站內(nèi)累計(jì)模型數(shù)超過80萬個(gè),涵蓋寫實(shí)、二次元、插畫、設(shè)計(jì)、攝影、風(fēng)格化圖像等多類型應(yīng)用場景,基本覆蓋所有主流創(chuàng)作風(fēng)格。

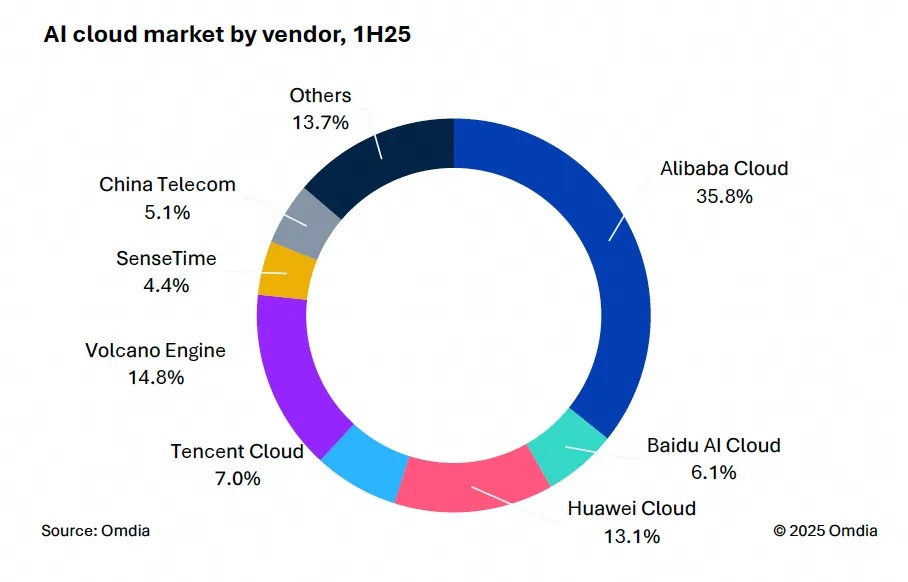

9月9日,國際權(quán)威市場調(diào)研機(jī)構(gòu)英富曼(Omdia)發(fā)布了《中國AI云市場,1H25》報(bào)告。中國AI云市場阿里云占比8%位列第一。

9月24日,華為坤靈召開“智能體驗(yàn),一屏到位”華為IdeaHub千行百業(yè)體驗(yàn)官計(jì)劃發(fā)布會(huì)。

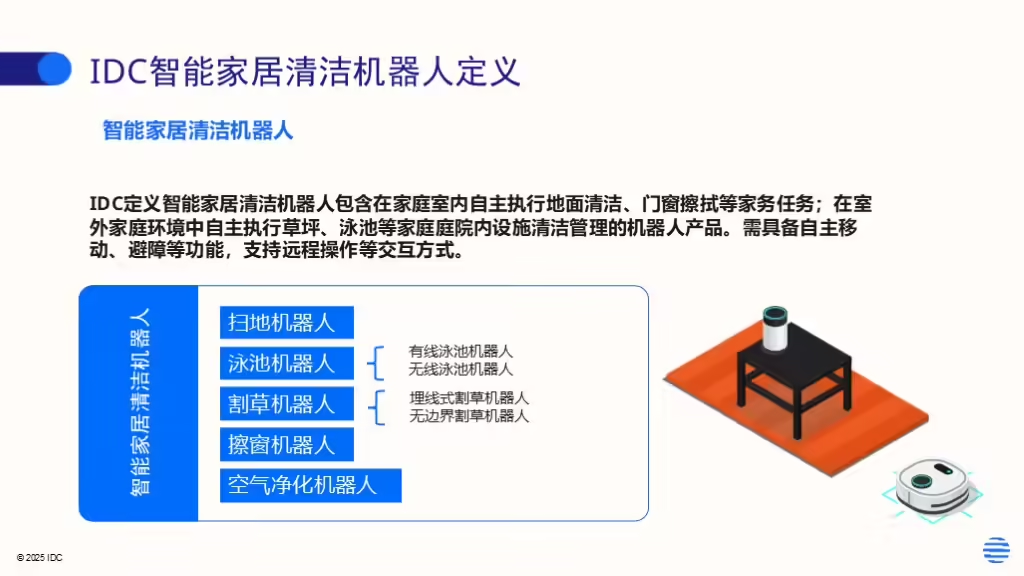

IDC今日發(fā)布的《全球智能家居清潔機(jī)器人設(shè)備市場季度跟蹤報(bào)告,2025年第二季度》顯示,上半年全球智能家居清潔機(jī)器人市場出貨1,2萬臺(tái),同比增長33%,顯示出品類強(qiáng)勁的市場需求。