6月12日消息,Meta 近日在 Github 上開源了其 AI 語言模型 MusicGen,該模型基于谷歌 2017 年推出的 Transformer 模型。MusicGen 主要用于音樂生成,它可以將文本和已有的旋律轉(zhuǎn)化為完整樂曲。

據(jù)IT之家報(bào)道,研發(fā)團(tuán)隊(duì)表示:“我們使用了 2 萬小時(shí)的授權(quán)音樂來對(duì)訓(xùn)練該模型,并采用 Meta 的 EnCodec 編碼器將音頻數(shù)據(jù)分解為更小的單元進(jìn)行并行處理,進(jìn)而讓 MusicGen 的運(yùn)算效率和生成速度都比同類型 AI 模型更為出色。”

除此之外,MusicGen 還支持文本與旋律的組合輸入,例如你可以提出生成“一首輕快的曲目”并同時(shí)要求“將它與貝多芬的《歡樂頌》結(jié)合起來”。

研發(fā)團(tuán)隊(duì)還對(duì) MusicGen 的實(shí)際表現(xiàn)進(jìn)行了測(cè)試。結(jié)果顯示,與谷歌的 MusicLM 以及 Riffusion、Mousai、Noise2Music 等其他音樂模型相比,MusicGen 在測(cè)試音樂與文本提示的匹配度以及作曲的可信度等指標(biāo)上表現(xiàn)更好,總體而言略高于谷歌 MusicLM 的水平。

文章內(nèi)容僅供閱讀,不構(gòu)成投資建議,請(qǐng)謹(jǐn)慎對(duì)待。投資者據(jù)此操作,風(fēng)險(xiǎn)自擔(dān)。

海報(bào)生成中...

海藝AI的模型系統(tǒng)在國(guó)際市場(chǎng)上廣受好評(píng),目前站內(nèi)累計(jì)模型數(shù)超過80萬個(gè),涵蓋寫實(shí)、二次元、插畫、設(shè)計(jì)、攝影、風(fēng)格化圖像等多類型應(yīng)用場(chǎng)景,基本覆蓋所有主流創(chuàng)作風(fēng)格。

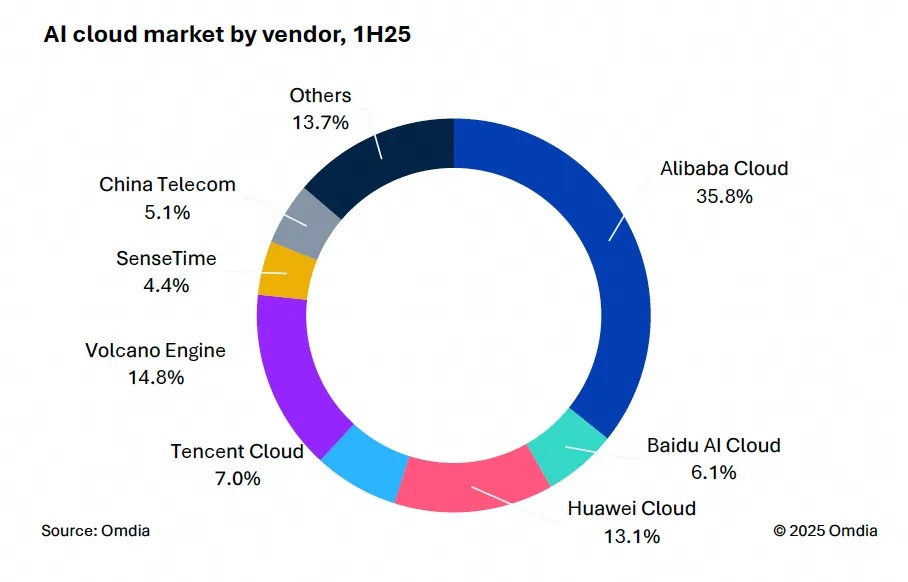

9月9日,國(guó)際權(quán)威市場(chǎng)調(diào)研機(jī)構(gòu)英富曼(Omdia)發(fā)布了《中國(guó)AI云市場(chǎng),1H25》報(bào)告。中國(guó)AI云市場(chǎng)阿里云占比8%位列第一。

9月24日,華為坤靈召開“智能體驗(yàn),一屏到位”華為IdeaHub千行百業(yè)體驗(yàn)官計(jì)劃發(fā)布會(huì)。

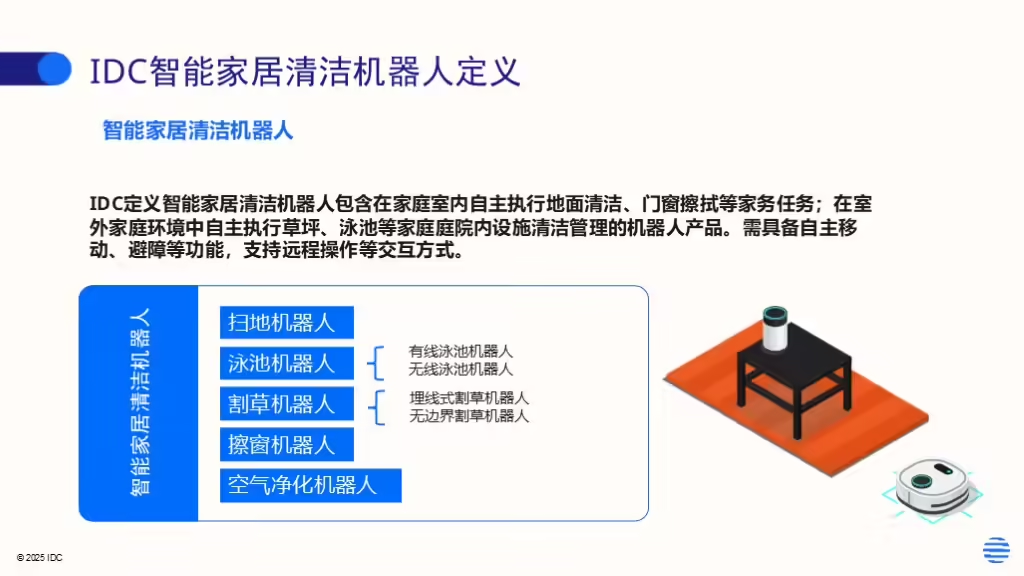

IDC今日發(fā)布的《全球智能家居清潔機(jī)器人設(shè)備市場(chǎng)季度跟蹤報(bào)告,2025年第二季度》顯示,上半年全球智能家居清潔機(jī)器人市場(chǎng)出貨1,2萬臺(tái),同比增長(zhǎng)33%,顯示出品類強(qiáng)勁的市場(chǎng)需求。