Anthropic公司近期發布了一項關于大型語言模型(LLM)安全防護的研究,揭示了當前AI模型在應對惡意攻擊時的脆弱性。研究表明,通過簡單的提示詞格式調整,如大小寫混合或單詞順序打亂,攻擊者可以輕松繞過AI模型的安全防護,誘導其生成有害內容。

為了驗證這一發現,Anthropic與牛津大學、斯坦福大學等機構合作,開發了一種名為“最佳N次”(BoN)的自動化越獄算法。該算法通過重復采樣提示詞的變體,并結合隨機打亂字母順序、大小寫轉換等手段,成功在多個主流AI模型上實現了超過50%的攻擊成功率。

研究人員在測試中使用了包括OpenAI的GPT-4、Anthropic的Claude 3.5、谷歌的Gemini系列以及Meta的Llama 3等模型。結果顯示,BoN越獄方法在10,000次嘗試內,均能成功繞過這些模型的安全防護。

此外,研究還發現,基于語音或圖像的提示方式同樣存在安全漏洞。通過改變音頻的速度、音調或添加噪音,攻擊者可以繞過語音提示的安全防護;而通過調整圖像的字體、背景顏色或大小,也能成功誘導AI模型生成不當內容。

Anthropic的研究并非僅為了揭示漏洞,而是希望通過生成大量攻擊數據,為開發更強大的防御機制提供支持。這一研究為AI安全領域敲響了警鐘,提醒開發者在追求模型性能的同時,必須更加重視安全防護的設計與優化。

文章內容僅供閱讀,不構成投資建議,請謹慎對待。投資者據此操作,風險自擔。

海報生成中...

海藝AI的模型系統在國際市場上廣受好評,目前站內累計模型數超過80萬個,涵蓋寫實、二次元、插畫、設計、攝影、風格化圖像等多類型應用場景,基本覆蓋所有主流創作風格。

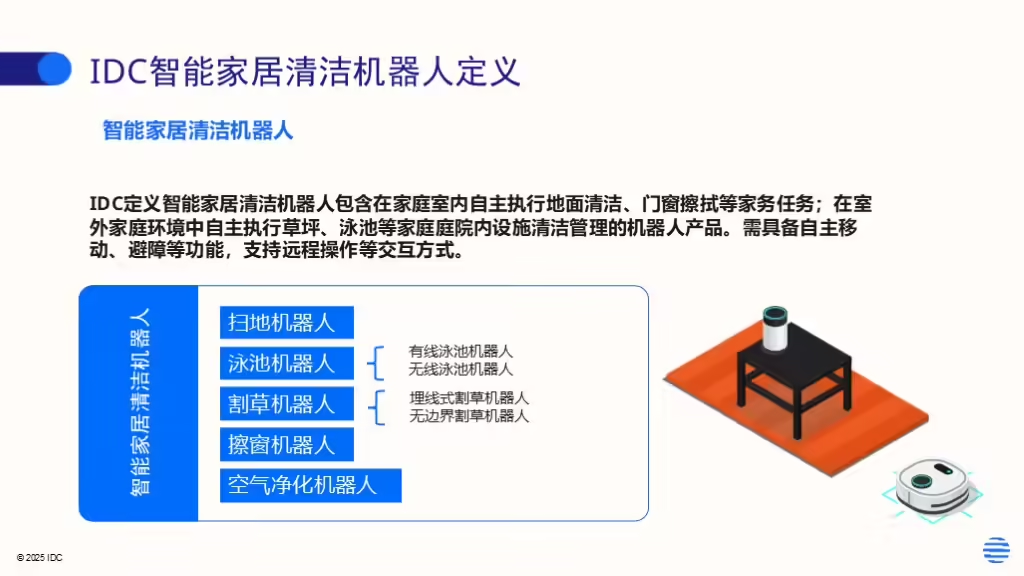

IDC今日發布的《全球智能家居清潔機器人設備市場季度跟蹤報告,2025年第二季度》顯示,上半年全球智能家居清潔機器人市場出貨1,2萬臺,同比增長33%,顯示出品類強勁的市場需求。