隨著企業越來越多地應用大型語言模型(LLMs),如何提升模型的知識準確性并減少幻覺現象,成為了一項重要挑戰。Meta AI 的研究人員在一篇新論文中提出了 “可擴展記憶層”,或許能夠為這一問題提供解決方案。

可擴展記憶層的核心思想是在不增加推理時計算資源的情況下,向 LLMs 中添加更多參數,從而提升其學習能力。這種架構適用于需要儲存大量事實知識但又希望保持推理速度的應用場景。

傳統的語言模型使用 “密集層” 來編碼大量信息。在密集層中,所有參數在推理時幾乎都是同時激活的,能夠學習復雜的函數,但這需要額外的計算和能量資源。而對于簡單的事實知識,使用具有關聯記憶架構的簡單層會更加高效和易于理解,這就是記憶層的作用。記憶層通過簡單的稀疏激活和鍵值查找機制來編碼和檢索知識。盡管稀疏層在內存占用上高于密集層,但其同時僅使用少量參數,從而提高了計算效率。

雖然記憶層已經存在多年,但在現代深度學習架構中卻鮮有應用,主要是因為它們并未針對當前硬件加速器進行優化。當前前沿的 LLMs 通常采用某種形式的 “專家混合” 架構,這與記憶層有相似之處。專家混合模型由多個專門化的小型專家組件構成,通過路由機制在推理時激活特定的專家。

為了克服記憶層在計算上輕便但內存占用大的挑戰,Meta 的研究人員提出了若干改進措施,使其能夠在大規模應用中實現可行性。他們為記憶層配置了并行化,能夠在多個 GPU 上存儲數百萬個鍵值對,同時不會減慢模型的運行速度。此外,他們還為處理高內存帶寬操作開發了特定的 CUDA 內核,并實現了參數共享機制,允許多個記憶層共享一組內存參數。

通過對 Llama 模型的修改,將一個或多個密集層替換為共享記憶層,研究人員對記憶增強模型進行了測試。他們的研究發現,記憶模型在多個任務中表現優異,特別是在需要事實知識的任務上,性能明顯超過密集基線,甚至能與使用2到4倍計算資源的模型競爭。

文章內容僅供閱讀,不構成投資建議,請謹慎對待。投資者據此操作,風險自擔。

海報生成中...

海藝AI的模型系統在國際市場上廣受好評,目前站內累計模型數超過80萬個,涵蓋寫實、二次元、插畫、設計、攝影、風格化圖像等多類型應用場景,基本覆蓋所有主流創作風格。

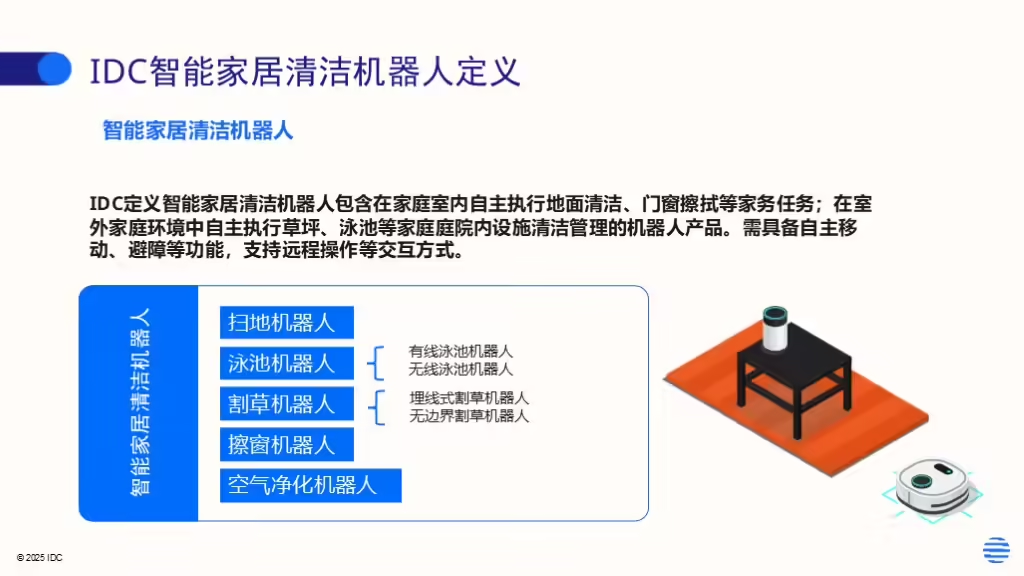

IDC今日發布的《全球智能家居清潔機器人設備市場季度跟蹤報告,2025年第二季度》顯示,上半年全球智能家居清潔機器人市場出貨1,2萬臺,同比增長33%,顯示出品類強勁的市場需求。