近日,Kordia委托Perceptive開展的一項獨立調查顯示,超過一半的Z世代新西蘭員工正在使用像ChatGPT或DalleE這樣的生成式AI工具,其中超過四分之一的人表示已經將其用于工作。然而值得注意的是,只有五分之一的受訪者意識到AI使用存在網絡安全或隱私風險。

Aura信息安全公司的首席顧問阿拉斯泰爾·米勒(Alastair Miller)表示,盡管AI具有潛力,但關于生成AI工具的許多問題企業簡單地忽視了。他認為,企業領導人需要提高對AI的認識,確保員工了解可接受的使用方式以及不當使用生成AI可能帶來的風險。

米勒指出,理解公共和私人生成式AI工具之間的區別對于領導者來說尤為重要。他舉出了三星的例子,員工在使用公共ChatGPT工具總結信息時,無意中泄露了源代碼和內部會議記錄。進入公共AI工具的數據將成為訓練數據池的一部分,而企業無法控制誰可能訪問它。因此,企業需要確保生成AI得到適當使用,任何敏感數據或個人信息遠離這些工具。

此外,調查的其他結果表明,各年齡段的新西蘭人對使用生成式AI工具的其他問題知之甚少。僅五分之一的受訪者擔心生成AI可能產生有偏見的輸出,三分之一的人擔心它可能產生不準確的信息或被用于信息誤導活動。

米勒表示,生成式AI的缺點之一是其容易出現“幻覺”。它像一個聰明的富有想象力的孩子,在某些情況下會制造與源相矛盾或在事實外觀下制造事實錯誤的內容。已經有記錄的生成AI幻覺事件給組織帶來問題。一家美國律師事務所因使用ChatGPT搜索支持客戶案件的法律先例而面臨制裁,這導致偽造的材料被提交法院。

米勒稱,某些數據絕不能委托給公共生成式AI工具。財務信息或商業敏感信息不應暴露于ChatGPT等公共AI工具,否則可能泄露商業優勢或甚至違反市場法規。與客戶數據或個人信息如健康記錄、憑據或聯系方式也是如此。

私人AI工具可能可以與敏感數據一起使用,但米勒仍表示應謹慎行事。即使是私人AI工具,在委托公司數據給它之前,也應進行安全評估,以確保有防護控制到位,從而獲得任何好處而不受后果影響。

米勒說,盡管存在風險,企業不應該回避AI。作為創新和生產力的偉大工具,許多主要軟件公司正在將AI融入日常業務技術,例如Microsoft365Copilot或Bing搜索。與任何新技術一樣,不要盲目采用,而是定義想要實現的價值或結果,這樣才能有效和安全地在組織中實現它。

文章內容僅供閱讀,不構成投資建議,請謹慎對待。投資者據此操作,風險自擔。

海報生成中...

海藝AI的模型系統在國際市場上廣受好評,目前站內累計模型數超過80萬個,涵蓋寫實、二次元、插畫、設計、攝影、風格化圖像等多類型應用場景,基本覆蓋所有主流創作風格。

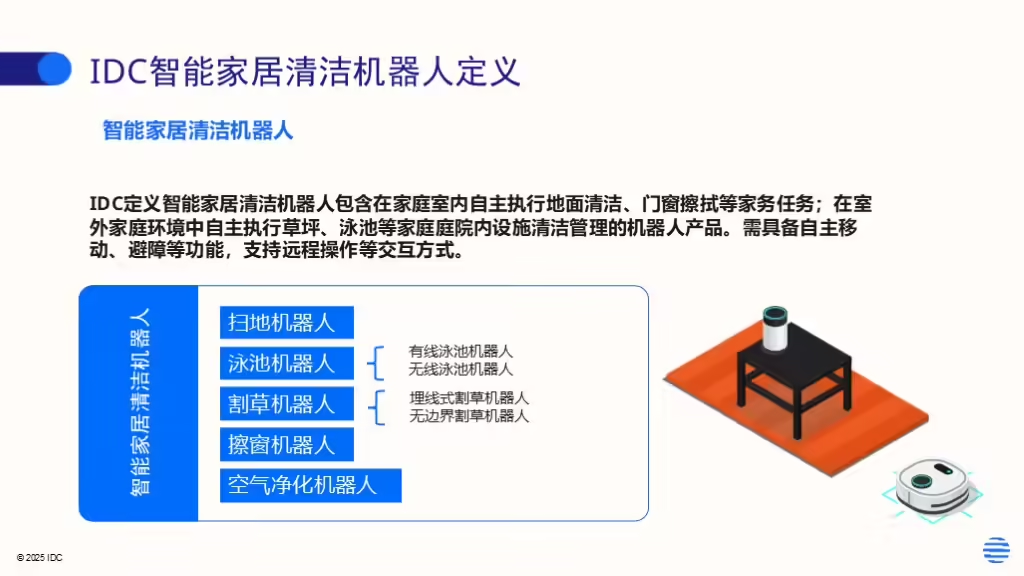

IDC今日發布的《全球智能家居清潔機器人設備市場季度跟蹤報告,2025年第二季度》顯示,上半年全球智能家居清潔機器人市場出貨1,2萬臺,同比增長33%,顯示出品類強勁的市場需求。