由顏水成和程明明領銜的研究團隊在Sora核心技術上進行了重要的升級,推出了Masked Diffusion Transformer V2。該模型在ImageNet benchmark上取得了驚人的成績,FID score達到1.58,刷新了State-of-the-Art(SoTA)。

作為Sora的核心技術之一,Diffusion Transformer(DiT)在圖像生成領域取得了顯著的成功,但其訓練成本隨著模型規模的增大而飆升。研究者發現,擴散模型難以高效地學習圖像中物體各部分之間的語義關系,導致訓練過程低收斂效率。為了解決這一問題,顏水成和程明明研究團隊提出了Masked Diffusion Transformer(MDT),通過引入mask modeling表征學習策略,顯著提升了DiT的訓練效率。

MDT采用了針對Diffusion Transformer設計的mask modeling表征學習策略,增強了模型對上下文語義信息的學習能力,并加強了圖像中物體之間語義信息的關聯學習。通過在擴散訓練過程中引入類似于MAE的mask modeling表征學習方案,MDT能夠重建不完整輸入圖像的完整信息,提升圖像生成的質量和學習速度。

具體而言,MDT通過VAE encoder將圖片映射到latent空間,并在latent空間中進行處理以節省計算成本。在訓練過程中,MDT首先mask掉部分加噪聲后的圖像token,并將剩余的token送入Asymmetric Diffusion Transformer來預測去噪聲后的全部圖像token。Asymmetric Diffusion Transformer架構包含encoder、side-interpolater和decoder,在訓練和推理階段分別處理未被mask的token和所有token,確保了模型的一致性。

最新版本的MDT,即MDTv2,通過更為高效的宏觀網絡結構進一步優化了diffusion和mask modeling的學習過程,實現了訓練速度的顯著提升。在ImageNet256基準下,MDTv2相較于DiT,不僅在訓練速度上提升了10倍以上,而且在生成質量上取得了更高的FID分數。MDTv2-S/2在400k步驟訓練下,FID指標為39.50,明顯領先于DiT-S/2的68.40。

總體而言,MDT的創新設計在擴散模型訓練中引入了有效的語義信息學習,提高了圖像生成的質量和訓練速度。研究者認為,通過視覺表征學習增強對物理世界的語義理解,有望提升生成模型對物理世界的模擬效果。這一工作符合Sora的期望,通過生成模型構建物理世界模擬器的理念,為未來的表征學習和生成學習研究提供了有力的啟示。

文章內容僅供閱讀,不構成投資建議,請謹慎對待。投資者據此操作,風險自擔。

海報生成中...

海藝AI的模型系統在國際市場上廣受好評,目前站內累計模型數超過80萬個,涵蓋寫實、二次元、插畫、設計、攝影、風格化圖像等多類型應用場景,基本覆蓋所有主流創作風格。

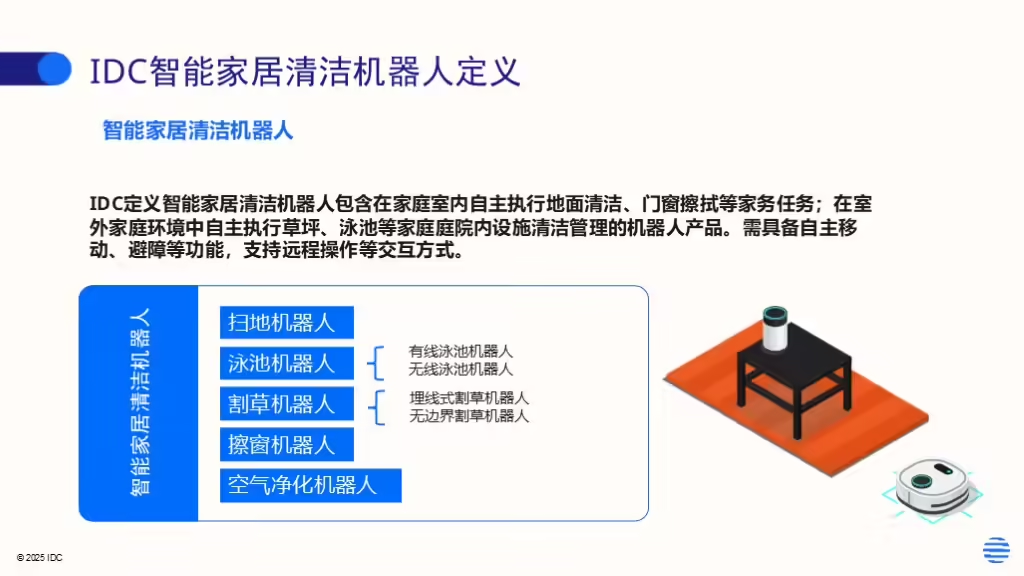

IDC今日發布的《全球智能家居清潔機器人設備市場季度跟蹤報告,2025年第二季度》顯示,上半年全球智能家居清潔機器人市場出貨1,2萬臺,同比增長33%,顯示出品類強勁的市場需求。