在大語言模型逐漸普及的今天,如何在資源受限的環境中實現高效部署已成為重要課題。為了解決這一挑戰,基于 Qwen2.5的輕量化大模型系列 DistilQwen2.5正式發布。該模型采用了創新的雙層蒸餾框架,通過優化數據和參數融合技術,不僅保留了模型的性能,同時顯著降低了計算資源的消耗。

DistilQwen2.5的成功得益于其獨特的知識蒸餾技術。這一過程首先需要大量高質量的指令數據,這些數據來自多個開源數據集及私有合成數據集。為確保數據的多樣性,研究團隊通過 Qwen-max 擴展了中英文數據,從而實現了任務和語言的均衡。此后,模型通過采用 “黑盒化蒸餾” 的方式,利用教師模型的輸出進行指令的擴展、選擇與改寫。這種方法不僅提升了數據的質量,還增強了模型的多任務處理能力。

值得注意的是,DistilQwen2.5還引入了白盒化蒸餾技術,通過模仿教師模型的 its 分布,使得學生模型在知識獲取上更為高效。這種技術避免了傳統白盒化蒸餾面臨的 GPU 內存消耗、存儲與讀取速度慢等問題。

經過多個權威指令遵循評測基準的測試,DistilQwen2.5的表現令人矚目,尤其是在 AlpacaEval2.0和 MT-Bench 的評測中表現優異。這標志著輕量化大語言模型的發展進入了一個新的階段,能夠在保證性能的前提下,大幅降低計算成本,進一步推動了 AI 技術在各種應用場景中的落地。

DistilQwen2.5的開源發布也將為更多開發者提供便利,使他們能更輕松地使用這一強大的工具,為人工智能技術的普及貢獻力量。

文章內容僅供閱讀,不構成投資建議,請謹慎對待。投資者據此操作,風險自擔。

海報生成中...

海藝AI的模型系統在國際市場上廣受好評,目前站內累計模型數超過80萬個,涵蓋寫實、二次元、插畫、設計、攝影、風格化圖像等多類型應用場景,基本覆蓋所有主流創作風格。

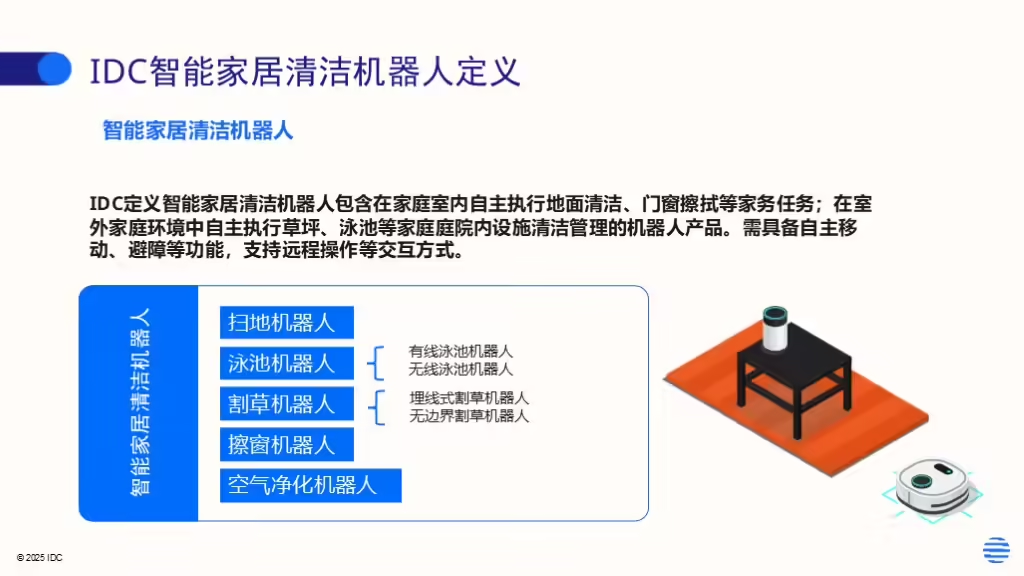

IDC今日發布的《全球智能家居清潔機器人設備市場季度跟蹤報告,2025年第二季度》顯示,上半年全球智能家居清潔機器人市場出貨1,2萬臺,同比增長33%,顯示出品類強勁的市場需求。